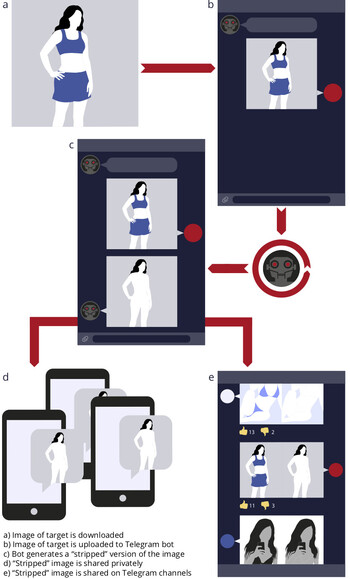

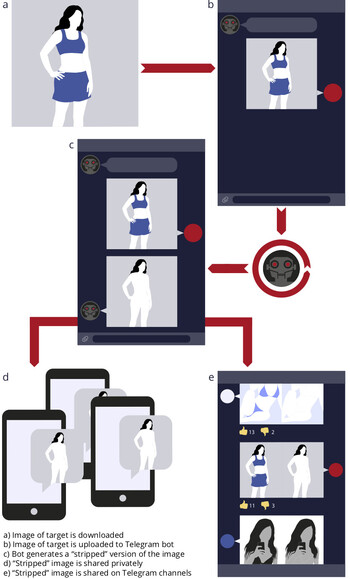

텔레그램을 통한 여성 가짜 알몸 사진 합성 개념도. ‘센시티’ 공개 자료

여성의 평범한 사진을 제공하면 인공지능을 이용해 가짜 알몸 사진을 만들어주는 행위가 텔레그램 대화방을 통해 벌어지고 있으며 전세계 피해 여성이 적어도 10만5천명이라는 추적 보고가 20일(현지시각) 공개됐다.

네덜란드 암스테르담에 있는 시각물 위협 분석 기업 ‘센시티’는 이날 ‘텔레그램을 활용한 딥페이크 봇’ 추적 보고서를 공개하고 지난해 7월 등장한 이 행위는 스마트폰으로 사진을 올리기만 하면 되는 편의성 때문에 지난 5~7월 세 달 사이 이용량이 2배 가까이 늘었다고 분석했다.

보고서는 “대화방에 사진을 올리면 자동 프로그램(봇)이 잠깐 뒤 가짜 알몸 사진을 합성해 제공한다”며 “이 프로그램은 여성 사진만 제대로 처리할 수 있다”고 지적했다. 또 가짜 합성 사진의 피해자 가운데 상당수는 미성년자라고 덧붙였다.

이 사진 합성과 관련된 대화방이 지난 7월말 기준으로 텔레그램에 7개 개설되어 있으며, 대화방 참가자는 10만3500여명이라고 보고서는 밝혔다. 이 기능은 무료로 이용할 수 있지만, 유료(기본 100 러시아루블·약 1500원)로 가입하면 ‘워터마크’ 없는 사진을 더 빨리 받을 수 있다. 이 대화방은 러시아의 소셜미디어 사이트 ‘브이케이’(VK) 등을 통해 주로 광고되고 있다.

분석팀이 이용자 7200명에게 물은 결과, 전체의 70%가 러시아·우크라이나 등 옛 소련 국가에 산다고 답했다. 또 6%는 스페인과 라틴아메리카 거주자였고, 4%는 중국·한국·일본 등 동아시아 거주자였다. 다른 지역들은 1~3% 수준이었다.

센시티는 “보고서 발간 직전 새로 발견한 관련 사이트 통계를 보니, 피해 여성이 68만명으로 나타났다”고 밝혀 실제 피해자는 훨씬 많을 것으로 우려된다. 조르조 파트리니 센시티 사장은 “소셜미디어 등에 공개 사진을 올린 모든 여성이 공격 대상이 될 수 있다”고 지적했다.

영국 <비비시>(BBC) 방송은 이 기능을 이용해 본 결과 합성 사진이 사실적이지는 않았다며 ‘피(P)’라는 운영자는 “이 행위는 폭력 행위와 무관한 오락일 뿐”이라고 주장했다고 전했다.

신기섭 선임기자

marishin@hani.co.kr